继续“消灭”画家?AI组合拳颠覆媒体创作模式!

作者:李琰敏

ControlNet的走红还要从这张背影照谈起。

一个女孩,在朋友圈发布了一张和三名朋友在沙滩合影的背影照。很普通的日常分享,照片有美感,但不多!

而后,一位名为@viggo 的大佬看到了这张照片,利用AI绘画进行了一些加工并发到社交软件上,继而引起了一场关于AI绘画的轩然大波。

viggo利用AI绘画前后进行了两次照片加工。第一次,他生成了两张极具美感的漫画照片,一改原图的暗淡,整个画面焕然一新。

最让人惊讶的是,AI并没有抹杀原图的姿态,而是将极大程度地保留了四位姑娘的姿势,比如左边第二位女孩是背着手的,这在生成的作品中也保留了下来。

也许是看到了网友们的热情,viggo紧接着又进行了第二轮的创作。这次的效果更为惊艳,无论从画面的层次感、线条感还是场景特效的使用,都让人眼前一亮。

随着自己画作的走红,viggo很敞亮地分享了制作方法。他自曝是借助了StableDiffusion和ControlNet的力量。

众所周知,Stable Diffusion是一款高性能模型,它生成的图像质量更高、运行速度更快、消耗的资源以及内存占用更小,是AI图像生成领域的里程碑。

01 那ControlNet是什么呢?

一个插件,它能对图像进行精确控制和调整。

ControlNet是一种基于控制点的图像变形算法,主要用于数字图像处理、计算机视觉和计算机图形学等领域。此外,它还可以根据给定的控制点对图像进行非线性变形,从而实现对图像的精确控制和调整。

我们先来看ControlNet的基本结构。ControlNet操纵神经网络块的输入条件,从而进一步控制整个神经网络的整体行为。这里「网络块」指的是一组神经层,它们被放在一起作为一个构建神经网络的常用单元,例如resnet块、多头注意力块、Transformer块。

概念抽象,一起看看它的出图效果吧!

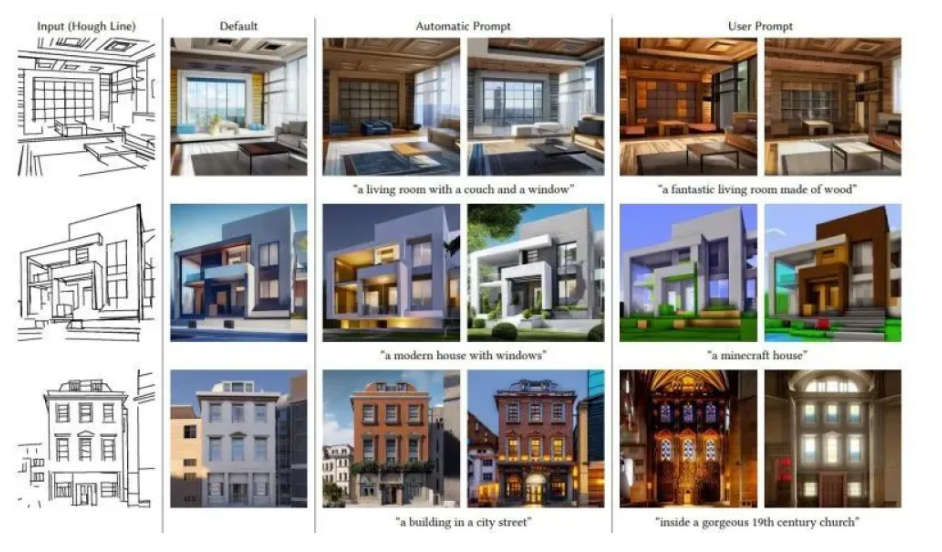

1、Canny边缘检测:通过从原始图像中提取线稿,生成相同构图的图像。

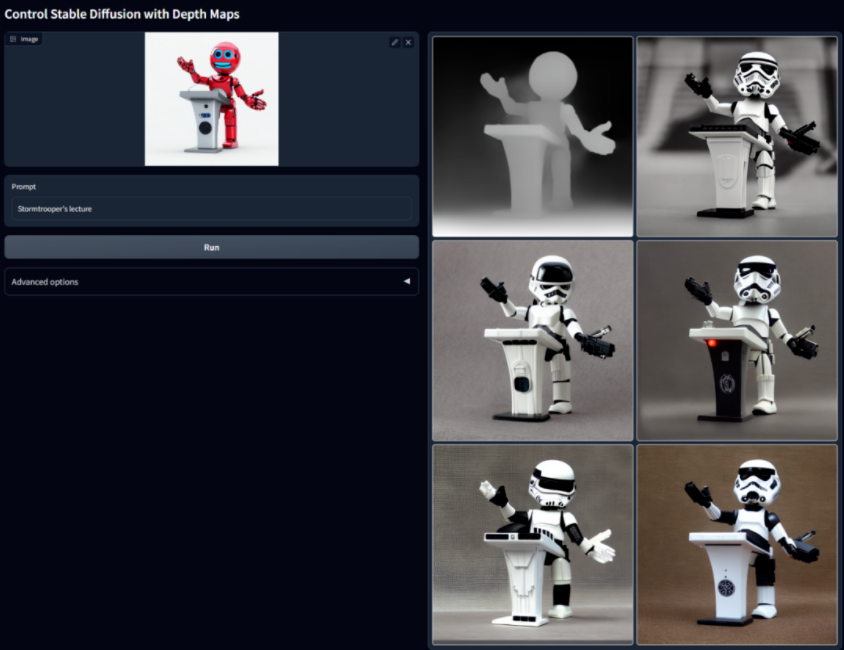

2、深度检测:通过提取原始图像中的深度信息,可以生成具有同样深度结构的图。

3、带有语义分割的ControlNet:

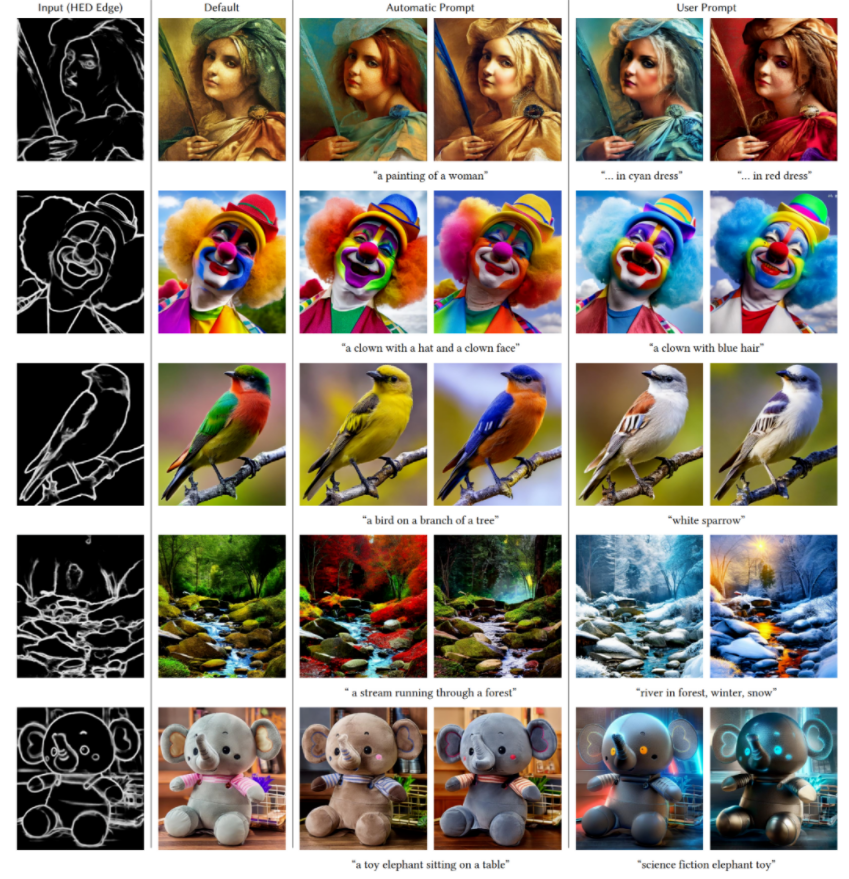

4、HED边缘检测图示

02 ControlNet强大在哪儿?——高度精细

它的优势在于能够在不失真的情况下对图像进行高度精细的调整。相比于其他基于网格或形状的图像变形算法,ControlNet的变形效果更加自然和平滑,能够更好地适应图像的特征。

简单来说,这一技术可以为AI扩散模型增加一个额外的输入,对AI的输出方向进行限制。如同在一望无际的沙漠上修建了道路与指示牌,为迷失方向的旅行者提供了前行的方向。

在ControlNet出现前,AI画师们想要产出具有特定特征的图像,就必须在“魔法咒语”上大下功夫——用户常常需要加上一系列的动作、位置修饰词语来描述图中角色的姿势、肢体特征等,即便这样,出图也依然需要大量的运气成分。

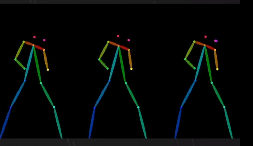

而利用ControlNet,AI可以通过草图、人体关键点特征、深度图、人体骨骼等特征按图索骥,产出满足特定要求的图片文件。

开篇提到四个女孩背影的生成,按照viggo的说法,他是先用 StableDiffusion图片转文字,再用Text2Prompt插件拓展找关键词,最后用ControlNet插件绑定骨骼开始换关键词尝试效果。

很多人认为,Stable Diffusion的发布是AI绘画生成发展过程中的一个里程碑。它给大众提供了一个可用的高性能模型,不仅生成的图像质量非常高,运行速度快,并且有资源和内存的要求也较低。不需要任何复杂的操作,只需要选择关键词,它就会创造出极具视觉效果的图像。

而ControlNet的出现解决了AI绘画的痛点。用关键词生成图片难免会有所瑕疵,尤其是在细节方面,而ControlNet能改善图生图效果,深入到很细微的地方。

不止于此,它还能实现线稿转全彩图,输入一张线稿图,得到的是填充好的图。

总之,用Stable Diffusion生成高质量的大图,辅以 ControlNet锦上添花,一张叹为观止的AI绘画就搞定了。

当然,它的强大远不止于此,除了能生成静态的图像,还能生成动态的视频!

03 ControlNet视频化思路

近期,#AI一键魔改视频#成为新近热议话题之一。其实,这就是ControlNet的视频版。它可以通过线稿提取、姿势检测,或模型识别等等方式,生成同样构图的画面。

比如,我们熟悉的IKUN、《泰坦尼克号》等都可一键生成魔改视频!

ControlNet的视频化思路有很多:

方法一:将原视频一帧一帧地导出,然后使用 ControlNet 转换每一张图片的风格。公认最繁琐的方式没有之一!

方法二:跟 EbSynth 结合,通过使用 ControlNet 生成关键帧。相较前一种,方便不少。

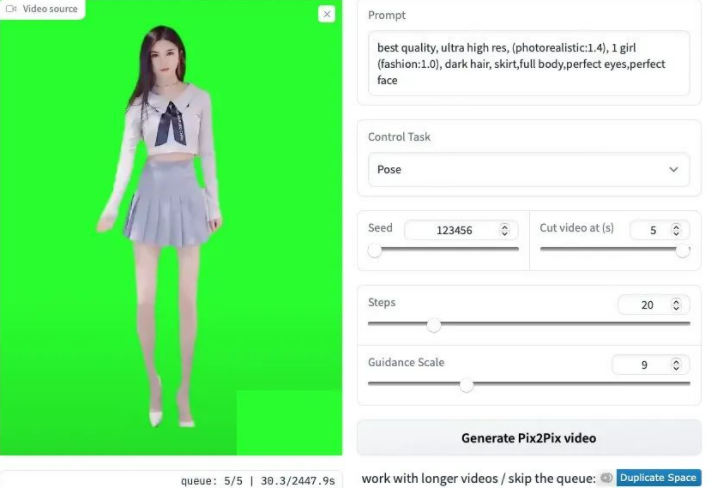

方法三:将ControlNet技术和Pix2PixVideo技术结合,开发了支持ControlNet的视频生成在线演示版,目前最简易的生成方式。

使用界面很简单,将原始视频导入,首先会将视频拆解成帧序列,并使用ControlNet中的Openpose模型检测出人体pose图,随后根据文本生成新的人像,由于有了pose图的控制,可以使人体姿势保持不变。

可见,随着技术的更新迭代, 会有越来越多类似ControlNet的技术涌入市场,不少人认为画师职业正面临着巨大威胁。

04 ControlNet不应让画师停止想象,而是助其更好地控制笔刷运作

随着AI绘画引入的ControlNet,将会带来一系列的影响。这项技术能够帮助机器完成更多的任务,提高生产力提高绘画质量和效率、增强人机交互、以及提供新的视觉体验。同时,这也意味着传统的艺术家可能会面临竞争压力。

随着越来越多的企业开始使用AI绘画来绘制图像,ControlNet技术也开始进入人们的视野。目前,许多企业都在尝试使用ControlNet技术来改进自己的图像绘制技术,并希望通过使用这项技术来获得更多的竞争优势。适用行业包括建筑行业、机械制造业、能源行业、医疗行业、政府机关等行业。

大家普遍认为这样可以更好地控制笔刷的“运动”,并且可以更精确地绘制出想要的图像。

总之,ControlNet对于人工智能和AI绘画的发展具有重要影响力,但绝不是让人类画师失去想象力的!未来,ControlNet的发展趋势是更具前瞻性的。

后附ControlNet安装教程:

前提:你要将AI绘画的WebUI更新到最新版本

拉取:

https://github.com/Mikubill/sd-webui-controlnet仓库中的内容拉取到WebUI文件目录下extensions文件夹内也可以直接下载zip

下载:

https://huggingface.co/lllyasviel/ControlNet/tree/main/annotator/ckpts,将其放到插件目录下的annotator下的ckpts目录

下载:

https://huggingface.co/webui/ControlNet-modules-safetensors/tree/main 下的模型到插件目录下的models目录

现在你的ControlNet已经安装完毕!

具体使用教程推荐B站视频:

https://www.bilibili.com/video/BV1Wo4y1i77v

问:AI绘画目前有哪些缺陷?

缺乏创造性:AI绘画目前只能根据已经存在的图像或数据生成新的图像,缺乏人类的创造力和想象力。虽然AI可以通过深度学习等方法提取出图像的特征和风格,并生成相应的图像,但AI缺少直觉、情感和创造力,难以创作出具有独特个性的艺术作品。

画面不真实:AI绘画虽然可以生成逼真的图像,但是在细节和纹理方面仍然存在不足,有时候生成的画面不够真实,容易被辨别出来。

依赖数据:AI绘画需要依赖大量的数据进行训练,缺少数据会影响生成图像的质量。同时,生成的图像也容易受到数据的限制,很难创造出超越数据范围的新图像。

模仿不足:AI绘画有时候只是简单地复制和重复已经存在的图像或风格,缺乏创新和突破,很难做到真正的模仿。

对话交互能力不足:目前AI绘画还缺乏对话和交互的能力,无法与用户进行真正的互动和创作,难以满足用户的个性化需求。

版权声明

本文仅代表作者观点,不代表区块链技术网立场。

本文系作者授权本站发表,未经许可,不得转载。

区块链技术网

区块链技术网

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。